Genmo.aiは、動画生成AIモデル「Mochi 1」を2024年10月24日にリリースしました。

Genmo.aiは、AIを活用した動画作成ツールの開発に注力する企業でDreamFusionの開発者やDatabricks、OpenAIの技術アドバイザーが所属しています。

この記事では、「Mochi 1」ローカル環境の使い方を初心者向けに詳しく解説します。

Mochi 1とは?

Mochi 1は、これまでに少なかった大規模なモデルを利用したオープンソースによる動画生成AIです。

テキストからリアルな動きの動画を生成でき、関連性の高い映像を構築することが可能です。

Mochi 1の大きな特徴は、下記の3つです。

- 大規模モデルによる圧倒的な生成パフォーマンス

- リアルで正確な動きを実現した生成技術

- ソースコードが公開されている「オープンソース」

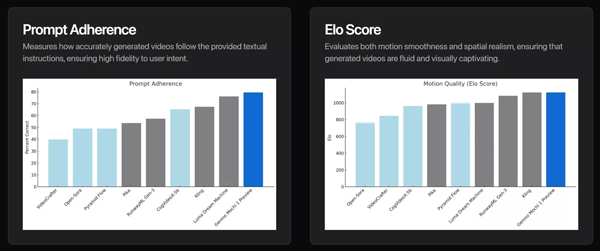

大規模モデルによる圧倒的な生成パフォーマンス

Mochi 1は、100億の学習パラメータを持つ大規模モデルにより、プロンプトから複雑なシーンを生成します。

ガイドライン適合性はOpenAI DALL-E 3プロトコルに基づくテストにより確認され、Gemini-1.5-Pro-002が使用されました。

プロンプトテキスト指示に対する適応性を高く持ち、より細かく生成への制御が可能です。

リアルで正確な動きを実現した動画生成技術

Mochi 1は、従来の動画、画像、テキストを組み合わせるアプローチではなく、動画データのみでトレーニングされています。

この専用アプローチにより、物理的な動きの品質が大幅に向上しました。

動画生成を成功させ、身体化された AI、ロボット工学、自動運転の解決に役立つ可能性のある世界最高のシミュレーターを構築することが最終的なビジョンであるとGenmoの開発者はコメントしています。

ソースコードが公開されている「オープンソース」

Mochi 1は、オープンソースで利用可能なモデルです。

現在は「リサーチプレビュー」としてApache 2.0 ライセンスでリリースされていて、自由にコードを利用することができます。

また、将来のアップグレードとして高解像度や高度なコンテンツ制御などが計画されています。

Stable Diffusionの使い方は、機能別に下記の記事にまとめているのでぜひご覧ください

Mochi 1 ComfyUIでの始め方・使い方

ここでは、「ComfyUI」上でのMochi 1の始め方から使い方まで紹介します。

Mochi 1は、多くのGPUパワーが必要になりますので、余裕をもって準備をしておきましょう。

今回は軽量化されたComfyUIで使えるプレビュー版をインストールして動画を生成してみます。

まずは「ComfyUI」を最新版に更新して、起動します。

Mochi 1が搭載されたカスタムノードをGitHubからダウンロードしてセットします。

「ComfyUI」での生成に使用するファイルは下記の3つです。

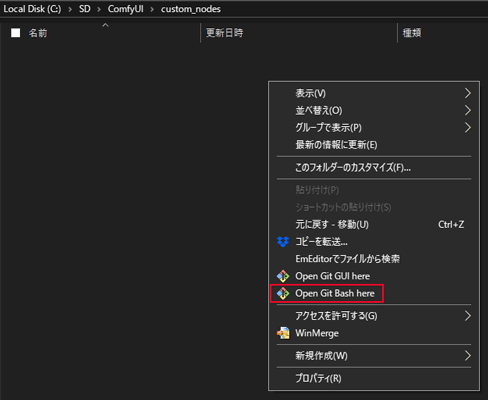

「ComfyUI」>「custom_nodes」を開き、フォルダ内で右クリックして「Open Git Bash here」を選択します。

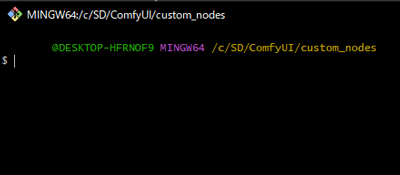

すると次のような「コマンド入力画面」が出てきます。

コマンド入力画面で「$」が表示されている行に下記のコマンドを入力します。

git clone https://github.com/kijai/ComfyUI-MochiWrapper.git

git clone https://github.com/kijai/ComfyUI-KJNodes.git

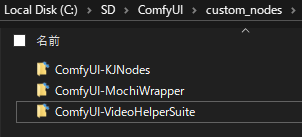

git clone https://github.com/Kosinkadink/ComfyUI-VideoHelperSuite.gitフォルダが3つ作成されれば完了です。

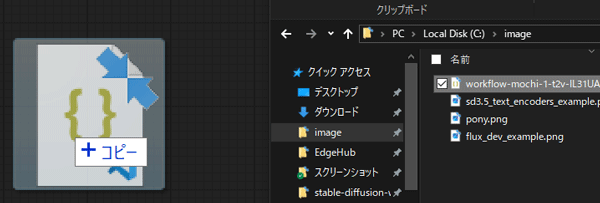

次に、ノードのパラメータをセットするComfyUI用のワークフローとクリップをダウンロードします。

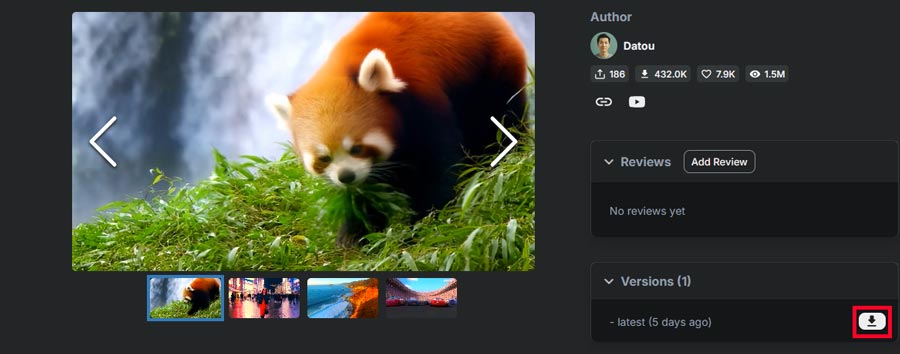

ComfyUIのワークフローを扱っているサイトOpenArt WorkflowsからMochi 1のワークフローをダウンロードします。

ダウンロードデータは右下にあります。

続いて、クリップファイルをHugging Faceからダウンロードします。

「ComfyUI」>「models」>「clip」の順で開き、先ほどダウンロードした「t5xxl_fp8_e4m3fn.safetensors 」を配置します。

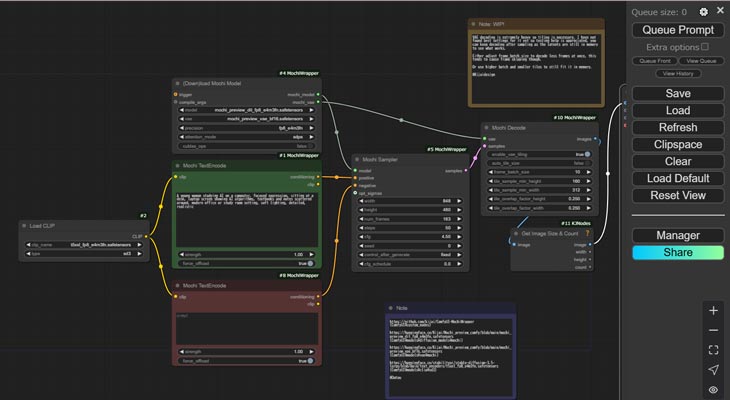

データのセットが完了したらComfyUIを起動してMochi 1用のワークフローをセットします。

ダウンロードした画像をComfyUIの画面にドラッグ&ドロップで画像を読み込むと埋め込まれているワークフローデータを表示することができます。

ComfyUIの生成開始画面で、ワークフローのノードが正常に反映されているか確認します。

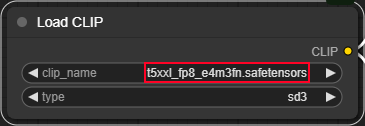

Load CLIPとPositive Promptを設定します。

Load CLIP

・clip_name1に「t5xxl_fp8_e4m3fn.safetensors」を選択します

・typeに「sd3」を選択します

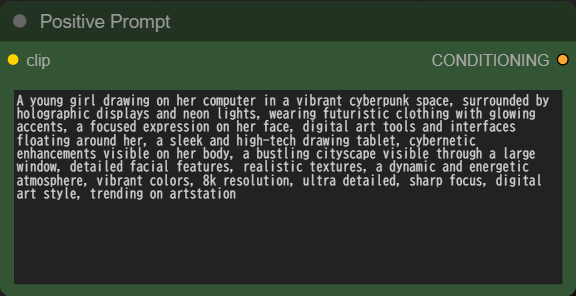

Positive Prompt

・生成したい動画のプロンプトを入力します。

各種のパラメータやプロンプト以外の入力項目は、入力しなくても問題ありません。

生成は右上の「Queue Prompt」ボタンをクリックします。

A cat walks around the house bipedally

動画をクリックするとそのまま再生でき、生成した動画は右クリックで保存できます。

スポンサーリンク

Mochi 1の料金プランと商用利用は?

Mochi 1の料金プランと商用利用に関して紹介します。

Mochi 1は、Apache 2.0ライセンスのもと無償でソースコードが公開されており、改良や再配布が可能です。

Mochi 1の商用利用は?

Mochi 1公式ブログでは、「個人使用および商用使用に自由に利用できます」とコメントされています。

さらに、Genmoが提供するプレイグラウンド(Web上での試用環境)も無料で利用可能です。

概要は以下の通りです。

Mochi 1を使いこなして生成AIをマスターしよう!

今回は、Genmoが公開した動画生成AIの最新モデル「Mochi 1」の使い方について紹介しました。

Mochi 1は、従来の動画生成サービスと比較して、最も最先端で質が高い動画を生成することができます!

無料で利用できる動画生成AIのオープンソースサービスの中でトップクラスなので、このチャンスに高性能ツールで動画生成を極めてみましょう。