FramePackは、lllyasviel氏が2025年4月に公開したオープンソースの動画生成AIです。

FramePackを使えば、素材画像+テキストプロンプトを入力するだけで、高品質な動画を簡単に作成できます。

この記事では、初心者にも分かりやすく、FramePackの概要とローカル環境での導入・使い方を解説します。

FramePack(フレームパック)とは?

FramePackは、動画の次のフレーム(または次のフレームセクション)を予測するニューラルネットワーク構造で、動画を段階的に生成する技術が利用されています。

FramePackの特徴は以下の通りです。

- 動画生成を効率化

-

FramePackは入力コンテキストを一定の長さに圧縮するため、動画の長さに関係なく生成の負荷が一定になります。

- 軽量な処理が可能

-

13Bモデル(130億パラメータを持つモデル)を使用して、非常に多くのフレームを処理できるため、ノートパソコンのGPUでも動作可能です。

- 大規模バッチサイズでの学習

-

FramePackは、画像生成(Image Diffusion)の学習で使用されるような大きなバッチサイズでの学習が可能です。

- 動画生成なのに画像生成のような感覚

-

動画生成を行うにもかかわらず、画像生成(Image Diffusion)に近い処理感覚で利用できます。

Stable Diffusionの使い方は、機能別に下記の記事にまとめているのでぜひご覧ください

FramePack GPUSOROBAN(Linux環境)での始め方・使い方

ここでは、「GPUSOROBAN」を使ったクラウド(ローカル)環境での「FramePack」の始め方から使い方まで紹介します。

FramePackは、多くのGPUパワーが必要になりますので、余裕をもって準備をしておきましょう。

最初にFramePack専用の環境を設定します。

同じPC内で異なるプログラムのバージョンを利用するには、ソフト専用の環境を作ります。そうすることでパッケージの競合を防ぐことができます。

ここでは、conda環境を利用して整えます。

下記のコマンドを入力して環境を新規で構築します。

conda create -n framepack python=3.10

conda activate framepack

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118環境の設定が完了したらデータのインストールに進みます。

下記のコマンドを入力して、FramePackプロジェクトをインストールします。

git clone https://github.com/lllyasviel/FramePack.git「FramePack」を開き、依存関係を取り除く追加データを入手します。

cd FramePack

pip install -r requirements.txt次に、動画を生成するためのモデルデータを入手します。

モデルデータはFramePackの初回起動時に自動でダウンロードされます。

起動コマンドを入力してFramePackを起動します。

python demo_gradio.py

立ち上がりまで数分かかりますので気長に待ちます。

Running on local URL: http://0.0.0.0:7860が表示されれば起動は完了です。

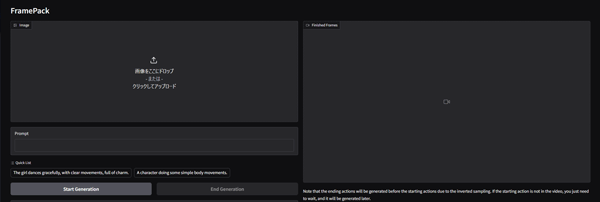

FramePackの起動画面

FramePackで動画を生成する素材の画像とプロンプトを用意します。

画像サイズがそのまま動画のサイズになるので大きさに注意しましょう。

画像をドラッグ&ドロップで読み込んで下部のプロンプト欄にプロンプトを入力します。

プロンプトには、画像に付けたい動きを入力します。

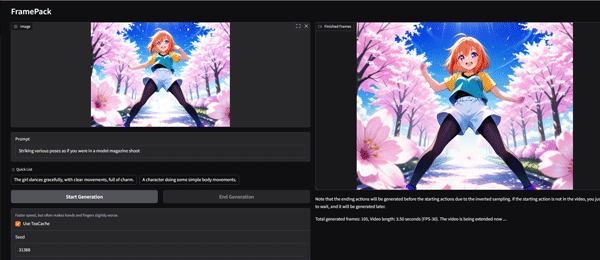

使用したプロンプト

A girl practicing dancing under a cherry blossom tree

入力し終えたら「Start Generation」ボタンをクリックして生成を開始します。

生成が完了すると右の画面にMP4出力の動画が表示されます。

生成パターンは1ファイルのみなので、もう一度生成したい場合はシード値を変えて再生成します。

FramePackで生成した動画

とても画質が良く、自然な仕上がりになりました。

スポンサーリンク

FramePack Windowsでの始め方・使い方

続いてPCを使ったローカル環境での「FramePack」の始め方から使い方まで紹介します。

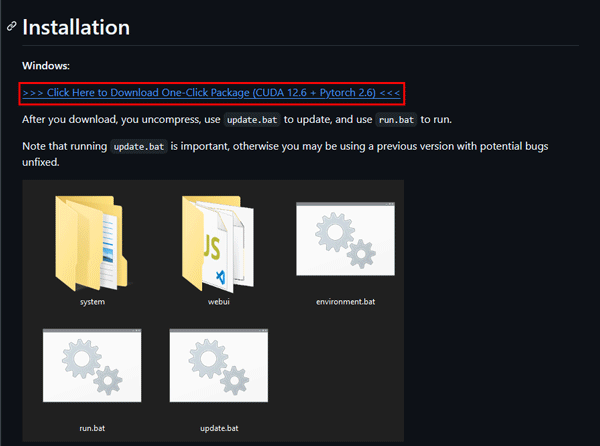

公式のGitHubページから圧縮ファイルをダウンロードします。

GitHub以外では配布されていないと注意喚起されているので他サイトからはダウンロードしないようにしましょう。

ダウンロードリンクはページ中部にあります。

ファイルは7-zip形式で圧縮されているので、解凍する場合は別途ソフトをインストールします。

FramePackを設置したい場所に圧縮ファイルを移動して展開します。

モデルファイルを含めて30Gほど必要となりますので注意しましょう。

展開するとフォルダと起動ファイルが格納されています。

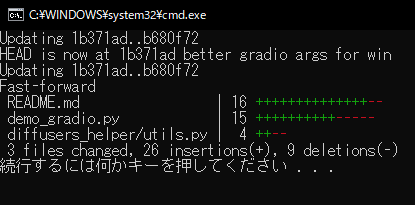

最初に「Update.bat」ファイルをクリックして更新を行います。

更新が完了したらキーを押してコマンド画面を閉じます。

次に「run.bat」ファイルをクリックしてアプリを起動します。

モデルファイルのダウンロードが始まり、初回起動まで数分かかりますので気長に待ちます。

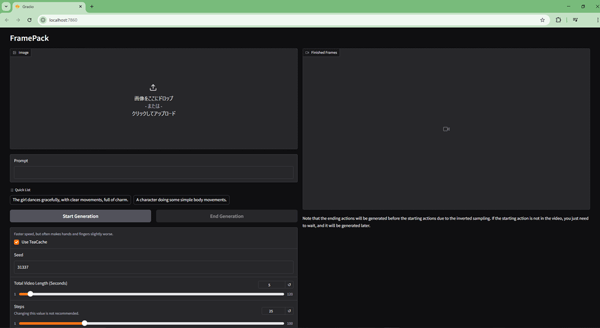

モデルファイルのダウンロードが終わるとGradioが立ち上がりWebUIが起動します。

最初に素材の画像を読み込みます。

素材の画像サイズがそのまま動画のサイズになるので注意しましょう。

使用したプロンプト

Striking various poses as if you were in a model magazine shoot

入力し終えたら「Start Generation」ボタンをクリックして生成を開始します。

FramePackで生成した動画

素材のイメージをそのままに、とても自然な仕上がりになりました。

FramePackの料金プランと商用利用は?

FramePackの料金プランと商用利用について解説します。

FramePackの公式プロジェクトはApache 2.0ライセンスのもとで提供されており、自由にコードを利用できます。

FramePackの商用利用は?

FramePackはApache 2.0ライセンスのもとで提供されており、商用利用を含めた幅広い用途での利用が認められています。

具体的には、以下のような利用例が許可されています。

- 商用利用

- コードの改変・再配布

- 特許の使用

ただし、今後、サービス提供時にライセンスが変更される可能性もあるため、商用プロジェクトで利用する際は、最新のライセンス情報を必ず確認しましょう。

FramePackのような動画生成AIにはクラウドGPUがおすすめ

FramePackをスムーズに利用するには、高スペックなパソコンが必要です。

ただし、FramePackを快適に利用できるような高性能なパソコンは、ほとんどが30万円以上と高額になります。

コストを抑えたい方へ:クラウドGPUの利用がおすすめ

クラウドGPUとは、インターネット上で高性能なパソコンを借りることができるサービスです。これにより、最新の高性能GPUを手軽に利用することができます。

クラウドGPUのメリット

- コスト削減:高額なGPUを購入する必要がなく、使った分だけ支払い

- 高性能:最新の高性能GPUを利用できるため、高品質な画像生成が可能

- 柔軟性:必要なときに必要なだけ使えるので便利

FramePackを使いこなして画像からの動画生成をマスターしよう!

今回は、lllyasviel氏が公開した動画生成AI「FramePack」の使い方について紹介しました。

FramePackは、気軽に利用できる生成AIツールとし完成度がとても高いモデルです。

無料で利用できる動画生成AIのオープンソースの中でトップクラスなので、このチャンスに高性能ツールで動画生成を極めてみましょう。