Wan2.2-Animateは、アリババの通義万相がリリースした素材を組み合わせて新たな動画を生成できるAIモデルです。

テキストや画像をもとに手軽に動画を作成できるだけでなく、既存の映像を滑らかなアニメーションへと変換することも可能です。

本記事では、この注目のAI「Wan2.2-Animate」の概要から、インストール前の準備、具体的な設定方法、基本的な使い方、応用テクニックまでを網羅的に解説します。

Wan2.2-Animateとは?

Wan2.2-Animateは、1枚の画像から人物、アニメキャラクター、動物を動画で動かすことができる最新のAIツールです。

この技術を使えば、実在の人物の写真はもちろん、自作のイラストなど、あらゆる対象を滑らかな動画に変換することが可能です。

以下のようなクリエイティブな活動で大きな力を発揮します。

- ショート動画制作: SNSで他の人とは一味違う、ユニークで目を引く動画コンテンツを誰でも手軽に作成できます。

- ダンステンプレート生成: 流行りのダンスや好きな振り付けを、お気に入りのキャラクターやアバターに踊らせるといった、楽しい動画を簡単に作れます。

- アニメ制作の支援: アニメーション制作における作画の手間を大幅に削減し、クリエイターがより創造的な作業に集中できるようサポートします。

このように、Wan2.2-Animateは専門的な知識がない方からプロのクリエイターまで、あらゆる人々の表現の可能性を大きく広げるツールになっているのです。

Wan2.2-Animateの技術的な特徴

Wan2.2-Animateで公式に公開されている技術解説は以下の通りです。

- 効果的なMoEアーキテクチャ

- Wan2.2は、動画向け拡散モデルにMixture-of-Experts(MoE)を導入。

- タイムステップごとにノイズ除去を専門のエキスパートモデルが分担し、計算コストを増やさずにモデル容量を拡大。

- シネマ級の美的表現

- ライティング、構図、コントラスト、色調などの詳細ラベル付きの美的データを厳選して学習。

- 映画的スタイルをより精密かつコントロール可能にし、好みの美的設定で動画生成が可能。

- 複雑なモーション生成

- Wan2.1比で、画像+65.6%、動画+83.2%の大規模データで追加学習。

- 動き・意味理解・美的表現の各次元で汎化性能が大幅に向上し、オープン/クローズド双方のモデル群でトップクラスの性能。

- 高効率な高解像度ハイブリッド TI2V(Text/Image to Video)

- 16×16×4の圧縮率を持つ高度なWan2.2-VAEを採用した5Bモデルをオープンソース化。

- テキストからの動画生成と、画像からの動画生成の両方に対応。

- 720P・24fpsをサポートし、RTX 4090など一般的なGPUでも動作。

- 現行最速クラスの720P@24fpsモデルとして、産業界と学術界の両方で活用可能。

従来は高額な計算資源が必要でしたが、映画品質の動画生成を、個人のクリエイターでも手の届く範囲に引き下げ、市場へのインパクトを大きく与えています。

Stable Diffusionの使い方は、機能別に下記の記事にまとめているのでぜひご覧ください

Wan2.2-Animate ComfyUIでの始め方・使い方

ここでは、「ComfyUI」を使ったローカル環境での「Wan2.2-Animate」の始め方から使い方まで紹介します。

ComfyUIの導入方法はこちらの記事で詳しく解説しています。

Wan2.2-Animateは、多くのGPUパワーが必要になりますので、余裕をもって準備をしておきましょう。

導入前に「ComfyUI」を起動して最新版に更新しておきましょう。

更新が完了したらデータのインストールに進みます。

「ComfyUI」>「custom_nodes」を開き、下記のコマンドを入力してWanVideoのプロジェクトをインストールします。

cd ComfyUI/custom_nodes

git clone https://github.com/kijai/ComfyUI-WanVideoWrapper.git「ComfyUI-WanVideoWrapper」を開き、依存関係を取り除く追加データを入手します。

cd ComfyUI/custom_nodes/ComfyUI-WanVideoWrapper

pip install -r requirements.txt次に、動画を生成するためのモデルデータを入手します。

動画生成に必要なモデルデータは下記の3つです。

- 動画のモデルデータ

- テキストエンコーダー

- VAE

- LoRA

- CLIP

- clip_vision

動画のモデルデータ

動画のモデルデータをHugging Faceからダウンロードします。

- Wan2_2-Animate-14B_fp8_e4m3fn_scaled_KJ.safetensors(18.4 GB)

「ComfyUI」>「models」>「diffusion_models」を開き、下記のコマンドを入力して動画のモデルデータをダウンロードして配置します。

cd ComfyUI/models/diffusion_models

wget https://huggingface.co/Kijai/WanVideo_comfy_fp8_scaled/resolve/main/Wan22Animate/Wan2_2-Animate-14B_fp8_e4m3fn_scaled_KJ.safetensorsテキストエンコーダー

動画のモデルデータをHugging Faceからダウンロードします。

- umt5-xxl-enc-bf16.safetensors(6.73GB)

「ComfyUI」>「models」>「text_encoders」を開き、下記のコマンドを入力して動画のモデルデータをダウンロードして配置します。

cd ComfyUI/models/text_encoders

wget https://huggingface.co/Kijai/WanVideo_comfy/blob/main/umt5-xxl-enc-bf16.safetensorsVAE

次にVAEのモデルデータをHugging Faceからダウンロードします。

- Wan2_1_VAE_bf16.safetensors(254 MB)

「ComfyUI」>「models」>「vae」を開き、下記のコマンドを入力してVAEのモデルデータをダウンロードして配置します。

cd ComfyUI/models/vae

wget https://huggingface.co/Kijai/WanVideo_comfy/resolve/main/Wan2_1_VAE_bf16.safetensorsLoRA

次にLoRAデータをHugging Faceからダウンロードします。

- WanAnimate_relight_lora_fp16.safetensors(1.44GB)

- lightx2v_I2V_14B_480p_cfg_step_distill_rank64_bf16.safetensors(738MB)

「ComfyUI」>「models」>「clip」を開き、下記のコマンドを入力してCLIPデータフォルダにダウンロードして配置します。

cd ComfyUI/models/loras

wget wget https://huggingface.co/Kijai/WanVideo_comfy/resolve/main/WanAnimate_relight_lora_fp16.safetensorscd ComfyUI/models/loras

wget wget https://huggingface.co/Kijai/WanVideo_comfy/resolve/main/Lightx2v/lightx2v_I2V_14B_480p_cfg_step_distill_rank64_bf16.safetensorsclip_vision

最後にclip_visionデータをHugging Faceからダウンロードします。

- clip_vision_h.safetensors(1.26GB)

「ComfyUI」>「models」>「clip_vision」を開き、下記のコマンドを入力してCLIPデータフォルダにダウンロードして配置します。

cd ComfyUI/models/clip_vision

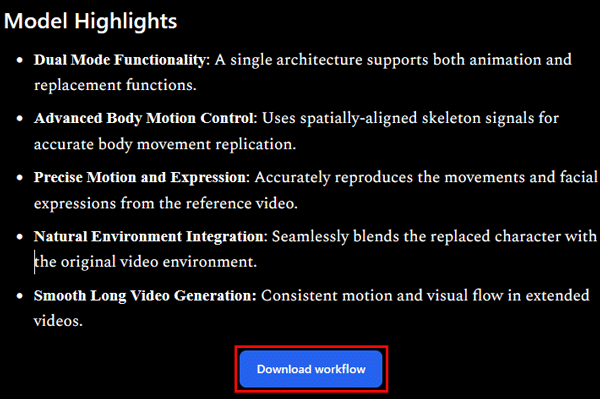

wget https://huggingface.co/Comfy-Org/Wan_2.1_ComfyUI_repackaged/resolve/main/split_files/clip_vision/clip_vision_h.safetensors今回は公式で配布されている総合ワークフローを使用します。

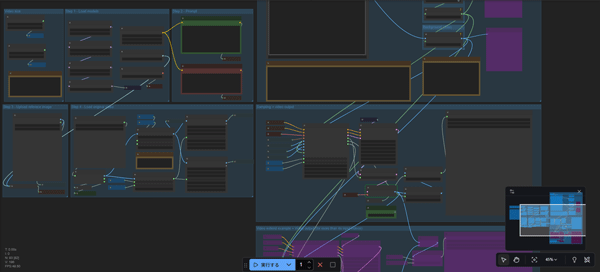

ワークフローデータは、公式に公開されている公式ワークフローをダウンロードして使用します。

ダウンロードしたワークフローデータをComfyUIの画面にドラッグ&ドロップで読み込みます。

ノードが正常に反映されているか確認します。

Wan2.2-Animateで使用する素材は、「画像データ1点」「動画データ1点」です。

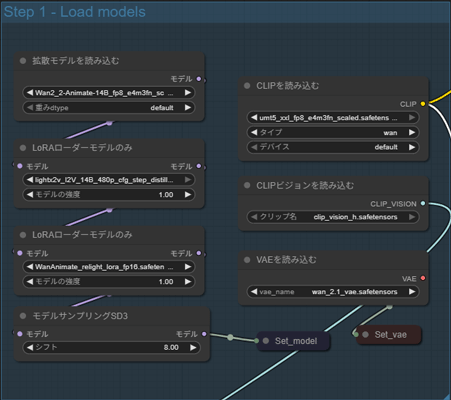

最初にWan2.2-Animate用のモデルデータをセットして準備を整えます。

・素材画像

動画に出演させたいキャラクター画像をアップロードします。

キャラクターの特徴やプロンプトをメモしておきます。

・素材動画

ベースとなる動きがあるベースの動画をアップロードします。

・モデルデータの設定

ダウンロードしたモデルデータが読み込めているかを確認しましょう。

不足がある場合はステップ❷に戻ります。

その他のパラメータはデフォルトのままで問題ありません。

プロンプトとネガティブプロンプトを入力して、画面上部の「▷Queueボタン」の右側に数字を入力する欄あるので生成したい動画の本数を指定します。

その後「▷Queue」ボタンをクリックして生成を開始します。

((ultra-detailed)),(professional logo:1.2), (highly detailed CG illustration), (best quality:1.2), anime, perfect face,(high resolution:1.5),(logo design art:1.2),Vivid Colors,cool,Messily painted,smooth vector,(white background),Logo design,(top Lighting:1.2), lustrous skin,(shine), depth of field, soft lighting, lighting, ray tracing, ultra-detailed,highly detailed,Anime 2D,manga, 8k, Anime illustration,(anime style boy:1.2), character is dancing in the garden

Wan2.2-Animate(ComfyUI)で生成した動画

スポンサーリンク

Wan2.2-Animateの料金プランと商用利用は?

Wan2.2-Animateの料金プランと商用利用について解説します。

Wan2.2-Animateの公式プロジェクトはApache 2.0ライセンスのもとで提供されており、自由にコードを利用できます。

現在、公式の料金プランは発表されていません。しかし、将来的にアリババクラウドなどのプラットフォームでAPI提供される可能性があると考えられます。

その際、他の生成AIサービスと同様に、計算資源に応じた従量課金制や月額プランが導入される可能性があります

Wan2.2-Animateの商用利用は?

Wan2.2-AnimateはApache 2.0ライセンスのもとで提供されており、商用利用を含めた幅広い用途での利用が認められています。

具体的には、以下のような利用例が許可されています。

- 商用利用

- コードの改変・再配布

- 特許の使用

ただし、今後、サービス提供時にライセンスが変更される可能性もあるため、商用プロジェクトで利用する際は、最新のライセンス情報を必ず確認しましょう。

Wan2.2-Animateのような動画生成AIにはクラウドGPUがおすすめ

Wan2.2-Animateで長尺の動画を生成するには、高スペックなパソコンが必要です。

ただし、Wan2.2-Animateを快適に利用できるような高性能なパソコンは、ほとんどが30万円以上と高額になります。

コストを抑えたい方へ:クラウドGPUの利用がおすすめ

クラウドGPUとは、インターネット上で高性能なパソコンを借りることができるサービスです。これにより、最新の高性能GPUを手軽に利用することができます。

クラウドGPUのメリット

- コスト削減:高額なGPUを購入する必要がなく、使った分だけ支払い

- 高性能:最新の高性能GPUを利用できるため、高品質な画像生成が可能

- 柔軟性:必要なときに必要なだけ使えるので便利

Wan2.2-Animateを使いこなして動画生成AIをマスターしよう!

今回は、動画生成AI・Wan2.1の最新バージョン「Wan2.2-Animate」の使い方について紹介しました。

Wan2.2-Animateは、あらゆる方法で動画生成が可能なオールインワンタイプのワークフローで。無料で利用することができます。

無料で利用できる動画生成AIのオープンソースの中でトップクラスなので、このチャンスに高性能ツールで動画生成を極めてみましょう。