Sakana AI(サカナAI)は、2024年7月22日に浮世絵風画像生成モデル「Evo-Ukiyoe」と浮世絵カラー化モデル「Evo-Nishikie」を公開しました。

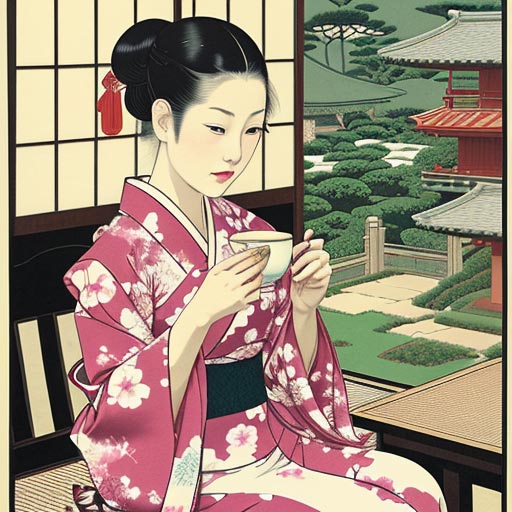

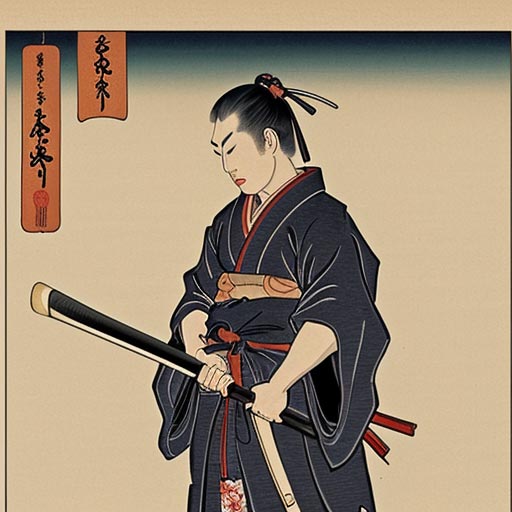

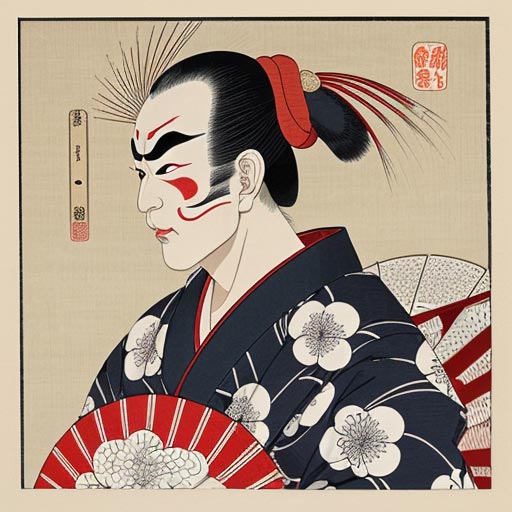

「浮世絵風画像生成モデル」とは、浮世絵作品を学習し、驚くほど美しい浮世絵風の画像を生成できるモデルです。

この記事では、Stable Diffusionを使った浮世絵風画像生成モデルの使い方とプロンプトを詳しく解説します。

Sakana AIの「Evo-Ukiyoe」とは?

Sakana AIが公開したEvo-Ukiyoeは、Stable Diffusion用のCheckpointであり、テキスト入力を通じて美しい浮世絵風の画像を生成できます。

Evo-Ukiyoeは、研究および教育を目的としてHuggingFaceサイトにモデルとデモが公開されています。

開発元のSakana AIは「歴史や文化を学ぶための新たなコンテンツ作成に利用され、浮世絵に関する興味を増すことにつながり、日本や世界の人々が浮世絵や日本文化に興味を持つきっかけを生み出すことを期待している」とコメントしています。

Stable Diffusionの使い方は、機能別に下記の記事にまとめているのでぜひご覧ください

Stable DiffusionにEvo-Ukiyoeモデルをセットする

Stable Diffusion Web UIを使って、Evo-Ukiyoeモデルで画像を生成する手順を紹介します。

Stable Diffusion Web UIを利用したことがない方は、HuggingFaceのサイトのデモページでも画像生成できます。

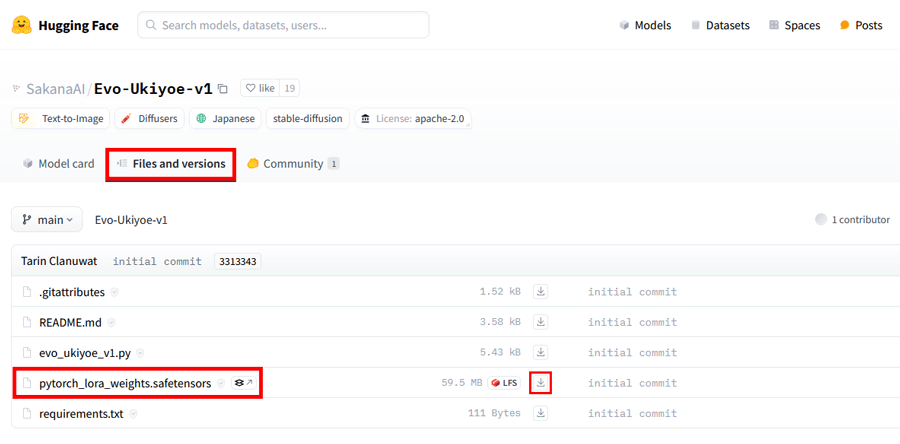

HuggingFaceにアクセスし、「Files and versions」タブをクリックします。

「pytorch_lora_weights.safetensors」を「↓ボタン」をクリックしてダウンロードします。

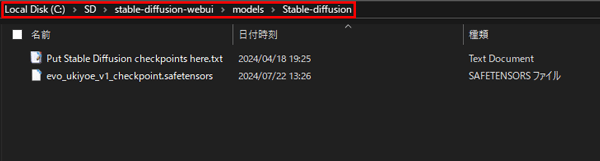

ダウンロードしたファイルをリネームします。

「pytorch_lora_weights.safetensors」のままでも利用できますが、後から何のモデルかわからなくなる可能性があります。

そこで、今回はわかりやすいファイル名「evo_ukiyoe_v1_checkpoint.safetensors」に変更します。

リネームした「evo_ukiyoe_v1_checkpoint.safetensors」を、Stable Diffusion「models」>「Stable-diffusion」の順で開き、「Stable-diffusion」の中にファイルを配置します。

これでセットは完了です。

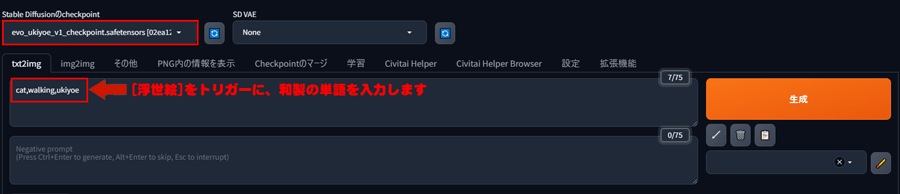

Stable Diffusion Web UIからEvo-Ukiyoeモデルを選択します。

プロンプトを入力して画像を生成します。

浮世絵により近い画像を生成するには、桜、富士山、着物、鳥など、浮世絵でよく取り上げられる要素をプロンプトに含めると効果的です。

一方、江戸時代に存在しないもの、例えばパソコンやハンバーガーなども生成はできますが、学習データに存在しないものを浮世絵風に生成することは難しく、全体として浮世絵らしくない画像が生成されることがあります。

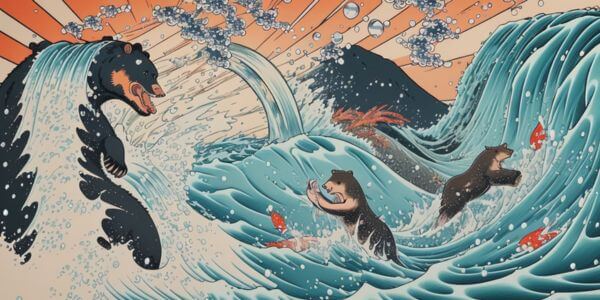

cat,walking,ukiyoe

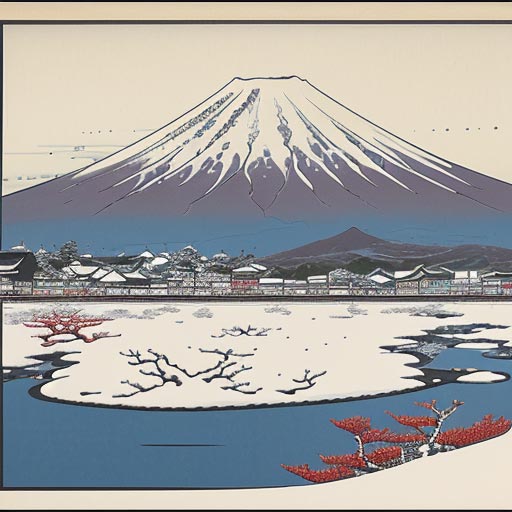

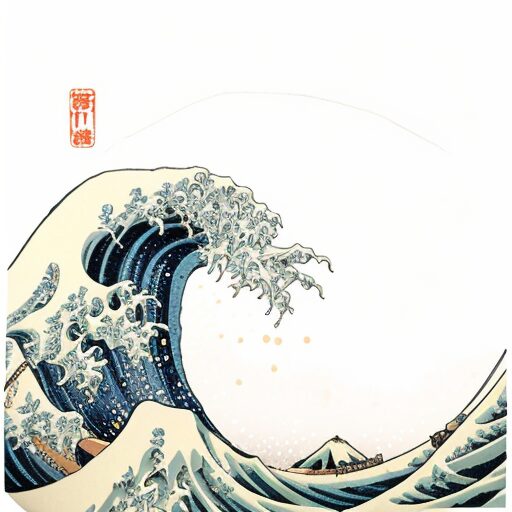

見事に浮世絵風の画像が生成されました。

単純なプロンプトですが細部までしっかり絵が構成されています。

Evo-Ukiyoeで有効なプロンプト

| トリガーワード | プロンプト |

|---|---|

| 鳥 | bird |

| 富士山 | fujisan |

| 着物 | kimono |

| 鬼 | oni |

| 侍 | samurai |

| 歌舞伎役者 | kabuki actor |

Evo-Ukiyoeモデルで生成する場合、専用の単語が必要です。

こちらで紹介するテキストプロンプト以外にも、古くからある和風のワードは生成に対応しやすくなっています。

鳥

bird

富士山

fujisan

着物

kimono

鬼

oni

侍

samurai

歌舞伎役者

kabuki actor

Sakana AIの「Evo-Nishikie」とは?

Sakana AIが公開したEvo-Nishikieは、Stable Diffusionのimg2img用の浮世絵風カラー生成モデルです。

このモデルを使用すると、浮世絵の画像にカラーを追加してカラーパターンを作成したり、ラフに対して浮世絵風の色塗りをしたりできます。

Evo-Nishikieも、Evo-Ukiyoe同様に研究および教育を目的にHuggingFaceサイト上でモデルとデモが公開されています。

Stable DiffusionのControlNetにEvo-Nishikieをセットする

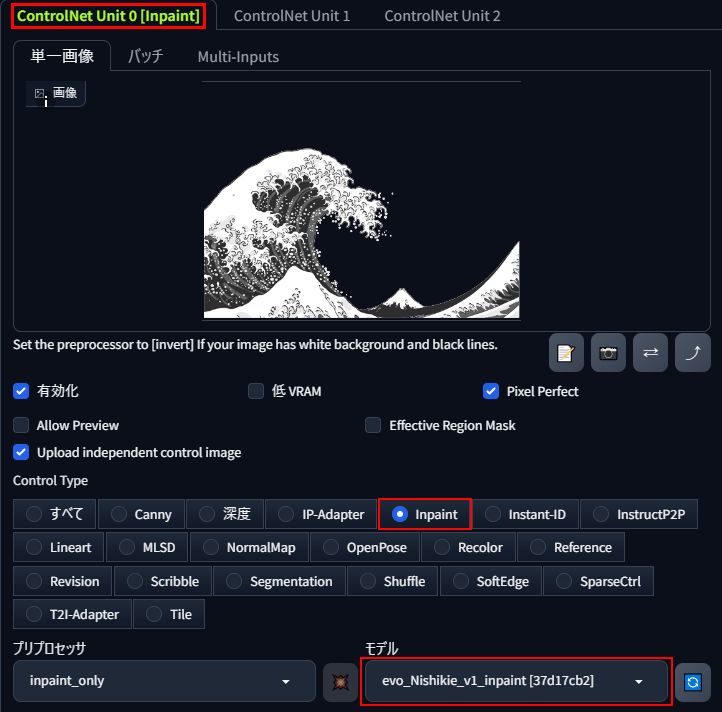

Evo-Nishikieは、Stable DiffusionのControlNet「inpaint」に対応しています。

入力したラフに対し、プロンプトに沿って浮世絵風に変換した画像を新たに生成します。

Stable Diffusion Web UIを利用したことがない方は、HuggingFaceのサイトのデモページでも画像生成できます。

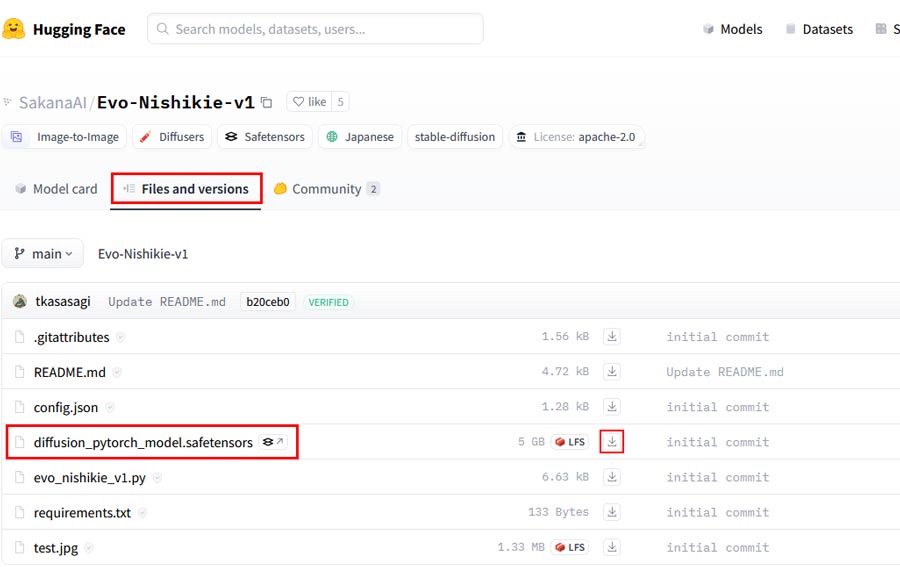

HuggingFaceにアクセスし、「Files and versions」タブを開きます。

「diffusion_pytorch_model.safetensors」を「↓ボタン」をクリックしてダウンロードします。

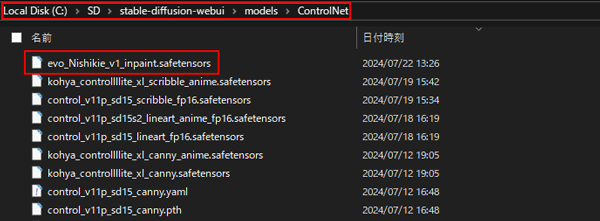

ダウンロードしたファイルをリネームします。

「diffusion_pytorch_model.safetensors」のままでも利用できますが、後から何のモデルかわからなくなる可能性があります。

そこで、今回はわかりやすいファイル名「evo_Nishikie_v1_inpaint.safetensors」に変更します。

リネームした「evo_Nishikie_v1_inpaint.safetensors」を、Stable Diffusion「models」>「ControlNet」の順で開き、「ControlNet」の中にファイルを配置します。

これでデータのセットは完了です。

Stable Diffusion Web UIからimg2imgタブを開いて、最下部にあるControlNetのパネルを開きます。

※ControlNetは拡張機能なので、実装していない場合は別途インストールが必要です。

inpaintを選択して素材画像を読み込み、ダウンロードしたNishikieモデルを選択します。

ControlNetの設定が完了したらプロンプト入力します。

着色に指定がなければプロンプト欄は空欄で問題ありません。

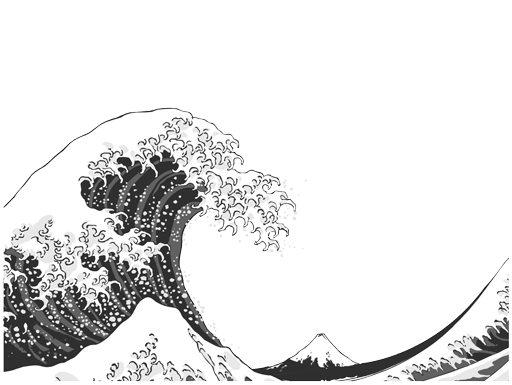

ラフ

Base

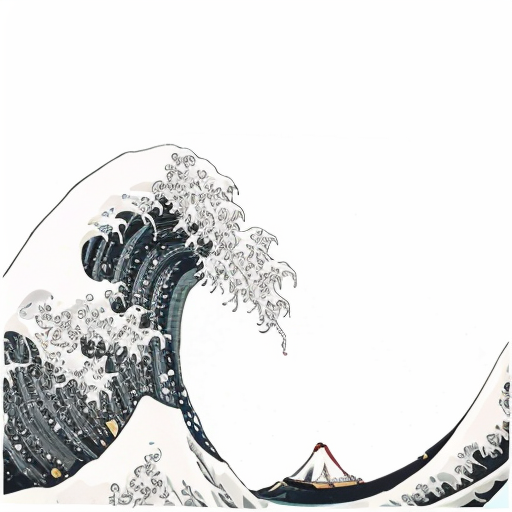

着色パターン弱

ノイズ除去強度: 0.4

着色パターン強

ノイズ除去強度: 0.65

見事に浮世絵風の画像が生成されました。

ノイズ除去強度(Denoising strength)で、着色の度合いを調整できます。

Sakana AIの浮世絵風モデルの商用利用について

Sakana AIのモデル使用ライセンスに関しては、商用利用は想定されていません。

Sakana AIは、「得られた結果に関わらず、本モデルの使用から生じる直接的、間接的、特別、偶発的、結果的な損害、または損失について責任を負わない。」としています。

Stable Diffusionで作成されたイメージは、一般的に「CC0 1.0 Universal Public Domain Dedication」に該当すると定義されています。

この定義は、商業利用を否定しておらず、著作権に関しては地域によって異なると解釈することができます。

Sakana AIの浮世絵風モデルを使いこなして新たなジャンルを切り拓こう!

今回は、Sakana AIがリリースした「浮世絵風画像生成モデル」の使い方について紹介しました。

使い方次第で新たな芸術ジャンルをAIで作り出せるモデルです。

Stable Diffusionを使用するのにスペックの高いパソコンが用意できない場合は、動作が遅くなることがあります。

効率的にStable Diffusionで画像を生成するには、16GB以上のVRAMが搭載されたパソコンが必要ですが、ほとんどが30万円以上と高額です。

コストを抑えたい方へ:今のパソコンのまま使える「PICSOROBAN」

PICSOROBANは、インストールの必要なくブラウザで簡単にStable Diffusionを利用できます。

さらに、今ならリリースキャンペーンとして無料会員登録するだけで、2,000ポイント貰えます!

詳しい使い方は下記の記事で紹介しています。

\約2時間無料で使える!/

Stable Diffusionが快適に使えるおすすめのパソコンやグラボに関しては下記の記事で紹介しています。