ControlNetのInstructP2Pは、お気に入りのキャラクターを生成し、そのベースを保ちながら差分を作り出すことができます。

Stable Diffusionで同じ内容のプロンプトを使った際に、毎回異なるキャラクター画像が生成されてしまう現象を防げます。

この記事では、ControlNet InstructP2Pの使い方と、その機能で何ができるのかについて解説します。

ControlNet InstructP2Pとは

ControlNetのInstructP2Pとは、「画像の生成過程を高度に制御するControlNetの仕組み」と「テキストによる自然言語指示で画像を編集できるInstructPix2Pix(InstructP2P)の仕組み」を組み合わせた拡張的な手法・モデルの総称です。

従来のAI画像の編集モデルは、不意に構図や形状を変えてしまうことがあります。しかし、ControlNetによって骨格・輪郭・エッジなどの情報を固定することで、元画像の一貫性を保ちながら編集できるのです。

ControlNet InstructP2Pの概要

Stable Diffusion のControlNetに実装されているのは、元画像のベースを保ちながら、一部だけ変更できる描画機能です。

ここでは、InstructP2Pでできる機能を紹介します。

自然言語による画像編集

たとえば「この写真を秋っぽい色合いに変える」「人物を笑顔にする」など、文章で記述した指示から画像を編集できます。

素材画像をベースのプロンプトに置き換えて、修正箇所を指示するだけで編集が可能になります。

微妙な変化から大きな変更まで対応

色合いや雰囲気の微調整、背景の大幅な変更や被写体の姿勢の変化など、多段階の編集を実行できる柔軟性を持っています。

素材の中から残したい部分を自由に選択できるため、創造性を発揮しやすい仕組みになっています。

既存のテキスト入力型画像生成モデルとの相性

Stable Diffusionや他のテキスト入力型モデルと組み合わせやすく、InstructPix2Pixの学習で得られた「編集力」を取り込むことで、より直感的な指示が可能になります。

テキストによる指示がそのまま画像編集に反映されるため、クリエイティブ制作のネックとなる時間効率を大幅に向上させることができます。

ControlNet InstructP2Pをインストールする方法

InstructP2Pは、素材画像と指定したいプロンプトが必要です。

ベースとなる素材画像は、なるべく情報が少ないシンプルな画像がおすすめです。

Stable Diffusionにインストール

InstructP2Pは、ControlNet内にインストールされているので、Stable Diffusion内にControlNetを実装すれば導入は完了します。

ControlNetのインストール方法はこちらで詳しく紹介しています。

ControlNetのインストールが完了したら、InstructP2Pに使用するモデルデータを必要に応じてダウンロードします。

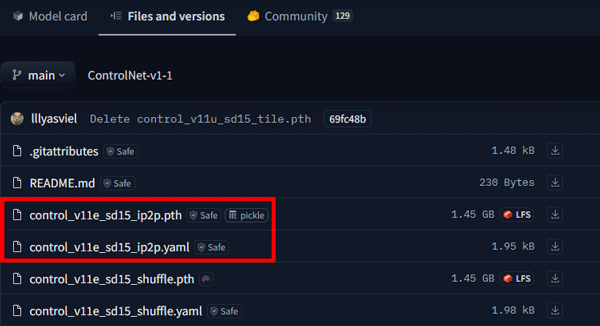

Hugging FaceにControlNetに関するモデルファイルの一覧があるので、その中のInstructP2Pのモデルファイルをダウンロードします。

SD1.5用ControlNetモデルデータ

https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/tree/main

- control_v11e_sd15_ip2p.pth

- control_v11e_sd15_ip2p.yaml

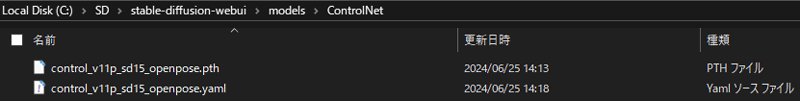

ダウンロードしたデータは、Stable Diffusionの「📁ControlNet」フォルダに移します。

実用性のあるSDXLのInstructP2Pモデルデータは公開されていないので、利用する際はSD1.5のモデルデータで生成を行います。

Stable DiffusionでControlNet InstructP2Pを使う準備

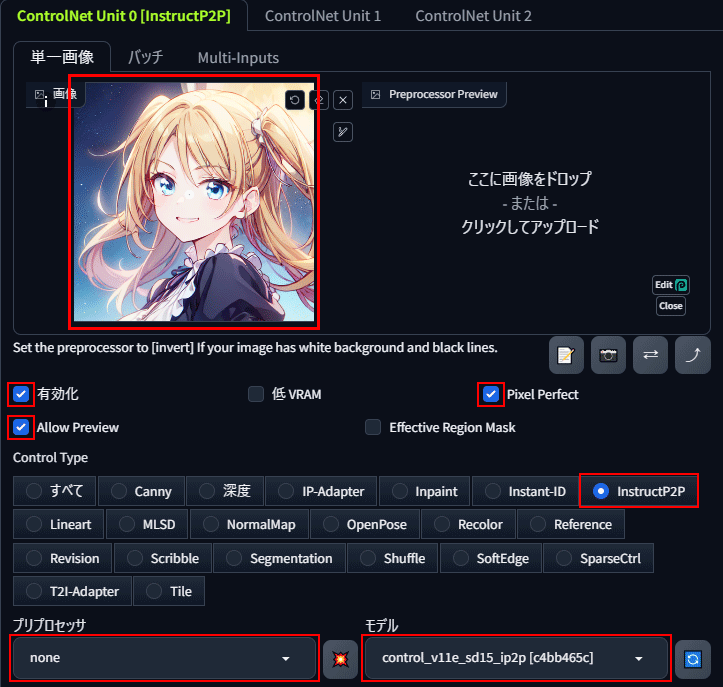

ControlNetのパネルを開いてInstructP2Pをセットしたら、◀マークをクリックしてパネルを開きます。

まずは、コンセプトの元になる素材画像を読み込みましょう。

「有効化」、「Pixel Perfect」、「Allow Preview」、「InstructP2P」にチェックを入れます。

プリプロセッサ「none」、モデル「control_v11e_sd15_ip2p」を選択します。

これでInstructP2Pのセットアップは完了です。

ControlNet InstructP2Pの使い方

セットアップが完了したら、編集対象となる画像を用意します。

次にプロンプトを入力します。

プロンプトの内容は、素材画像に対して変更するポイントを命令文形式で指定します。

素材画像のキャラクターの髪色を赤に変更して生成してみます。

make her pastel red hair:彼女の髪をパステルカラーの赤にする

次に服装を浴衣に変更します。

make her wear a yukata:彼女に浴衣を着せる

しかし、背景や髪型なども浴衣に合わせて変更されてしまいました。

変更したくない要素がある場合は、プロンプトに維持したい情報を残して生成しましょう。

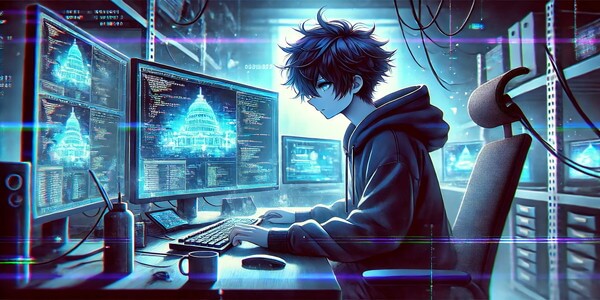

最後に、思い切って男性に変更してみます。

to a handsome man:ハンサムな男性に

雰囲気を維持しながら変更できました。

ControlNet InstructP2を使うならPICSOROBANがおすすめ

Stable DiffusionのInstructP2Pを最大限活用するには、生成回数を重ねて仕上げていく必要があります。

効率的にStable Diffusionで画像を生成するには、16GB以上のVRAMが搭載されたパソコンの利用がおすすめです。

しかし、高性能なパソコンの多くがが30万円以上と高額になります。

そのような時は、PICSOROBANがおすすめです。

コストを抑えたい方へ:今のパソコンのまま使える「PICSOROBAN」

ピクソロのメリット

- すぐ使える:高額PC不要で、ブラウザからすぐに利用可能。必要な分だけポイントを購入できます。

- リーズナブル:30分約60円で利用可能。さらに今なら約2時間分が無料。

- 無制限作成:時間内であれば、何枚でも画像生成可能。短時間で多くの作品を生成できます。

PICSOROBANは、インストールの必要なくブラウザで簡単にStable Diffusionを利用できます。

さらに、今ならリリースキャンペーンとして無料会員登録するだけで、2,000ポイント貰えます!

詳しい使い方は下記の記事で紹介しています。

\約2時間無料で使える!/

Stable Diffusionが快適に使えるおすすめのパソコンやグラボに関しては下記の記事で紹介しています。