NVIDIAの最新GPUであるH200は、AIやHPC分野で求められる計算能力を飛躍的に向上させた製品です。

本記事では、H200とは何か、その技術的な特徴や具体的な活用方法について掘り下げていきます。

さらに、NVIDIA H200を導入する際に起こりうる問題点や、それを解決した実例などについて、分かりやすく整理して解説します。

NVIDIA H200の概要と特徴

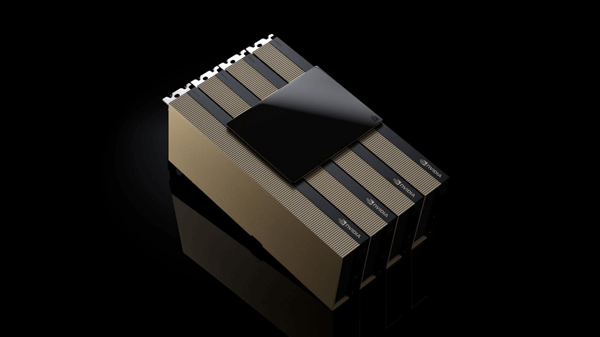

NVIDIA H200は、AIや高性能コンピューティング(HPC)向けに設計された最新のGPUです。

Hopperアーキテクチャを採用しており、前世代のNVIDIA H100の後継として位置づけられています。

特に、大規模言語モデル(LLM)の処理能力向上に重点が置かれており、AIワークロードにおいて飛躍的な性能向上を実現しています。

NVIDIA H200とは?

NVIDIA H200は、Hopperアーキテクチャを採用した最新世代のGPUで、NVIDIA H100の後継にあたります。

特に大規模言語モデル(LLM)の推論やデータ解析など、高度なAIワークロードに対応するよう設計されています。

NVIDIA H100から強化されたメモリ性能や高い並列処理能力により、大規模データの処理がより迅速かつ効率的に行える点が大きな特徴です。

また、第4世代TensorCoreを搭載することで、FP8やFP16といった低精度演算を中心とした行列計算が大幅に高速化し、多様なAIタスクを高速に実行できます。

このようにNVIDIA H200は、AIやHPC(ハイパフォーマンスコンピューティング)分野での利用を想定し、次世代のコンピューティング基盤として注目を集めています。その高効率な演算処理と拡張性から、多くの企業や研究機関での採用が進んでいます。

NVIDIA H200 vs H100 性能比較表

NVIDIA H200はH100の後継モデルとして、主にメモリ容量(80GB→141GB)とメモリ帯域幅(3.35TB/s→4.8TB/s)が大幅に向上している点がポイントです。

計算性能(FP64、FP32、Tensor性能)は両モデルで同等ですが、H200はより大規模なAIモデルの推論や、メモリを集約的に使用するワークロードにおいて優位性を発揮します。

電力消費やその他の仕様は基本的に同じです。

NVIDIA H200とH100の性能比較表を作成しました。

| 機能 | NVIDIA H100 | NVIDIA H200 |

|---|---|---|

| GPU メモリ | 80GB | 141GB |

| メモリ帯域幅 | 3.35 TB/s | 4.8 TB/s |

| Tensor性能 | 1,979 TFLOPS | 1,979 TFLOPS |

| NVLink | 900 GB/s | 900 GB/s |

| PCIe | Gen5 x16 | Gen5 x16 |

| 消費電力 | PCIe版 350W SXM版 700W | SXM版 700W |

- H200の優位点

-

- より大きなモデルの推論が可能

- メモリ集約的なワークロードでの性能向上

- より高いメモリ帯域幅による効率改善

- 共通点

-

- アーキテクチャ

- 計算性能(FP64, FP32, Tensor)

- 電力消費(700W)

- NVLink接続性能

H200はH100の進化版として、メモリ容量とメモリ帯域幅を大幅に向上させたモデルです。

計算性能は同等ですが、より大規模なAIモデルや、メモリを多く必要とするアプリケーションにおいて、H200が優位性を発揮します。

NVIDIA H200導入時に発生する主な問題

実際にNVIDIA H200を導入する際は、慎重に検討する必要があります。

実際の運用を考える上で想定される主な課題は、次のとおりです。

コストの高さ

NVIDIA H200は1台あたり5,000万円以上で取引される場合があるため、資金に余裕のない企業や研究機関には導入が難しい場合があります。

また、減価償却に長い期間を要するため、技術が急速に進化するなかで投資額を回収できないリスクも考慮する必要があります。

施設(データセンターなど)の設備面で発生する問題

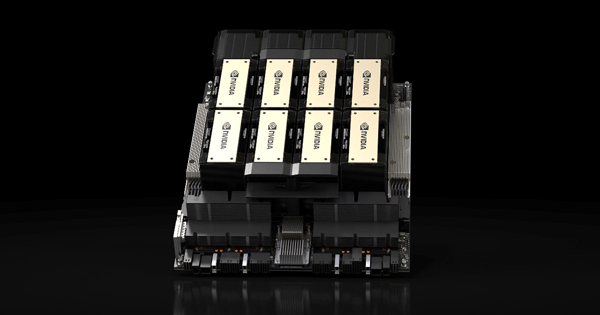

NVIDIA H200を8基搭載したクラスタシステムでは消費電力が10kWに達し、一般的なデータセンターの1ラック当たりの給電量(約6kW)を大きく上回ります。大規模なGPUを動かすには膨大な電力が必要であり、その分だけ料金が高額になります。

また、高発熱のGPUを安定して稼働させるためには強力な空調設備・冷却システムが必須で、施設のスペースや配線工事なども対応が必要となります。

システム面でも頻繁な保守が必要になるため、インフラエンジニアの負担が大きくなります。

技術革新の速さと投資リスク

GPUの開発スピードが非常に速いため、1年後にはより高性能な新モデルが登場する可能性が高いです。このため、いつ導入するべきか、導入コストを回収できるかといった投資判断が難しくなります。

こうした課題を踏まえ、導入に先立ってコスト見積もり・設備計画・運用体制・ソフトウェア面の方針を明確に固めておきましょう。

初期投資ゼロでNVIDIA H200を導入!GPUクラウド「GPUSOROBAN」のメリット

NVIDIA H200導入時の課題に対してGPUクラウド「GPUSOROBAN」を活用することで、以下のような具体的な解決策が得られます。

コストだけでなく、システム管理や保守に関するリスクを気にせず使えるので、気軽に導入できます。

クラウド利用によるコスト削減例

初期費用ゼロ・月額制

オンプレミスで導入すると数千万円規模の初期投資や保守費用が必要になりますが、クラウドなら初期費用が不要で、月額制の課金ですみます。

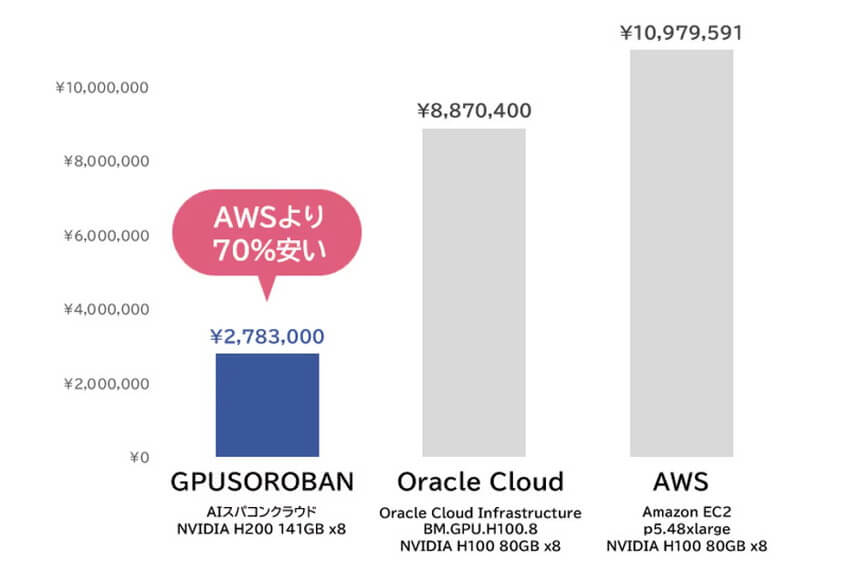

GPUSOROBANのNVIDIA H200を搭載したAIスパコンクラウドは月額278万円から利用でき、必要な期間・台数だけ契約できるので、ムダなコストを抑えられます。

無料トライアルや長期/複数台割引

GPUSOROBANの30日間の無料トライアルや、長期・複数台利用時の大幅割引など、利用状況に応じたコスト最適化プランが用意されています。

予測可能なワークロードに最適で、安定した使用が見込まれる場合にプランが選択できます。

開発環境に合わせたインスタンスの柔軟性

GPUSOROBANでは、用途に合わせたインスタンスタイプを最適化してNVIDIA H200のリソースを有効利用することができます。

システムを固定して利用するオンプレミス型では実現できない、高い柔軟性を享受できるという利点があります。

リスク回避型のクラウドソリューション

環境構築・運用コストの削減

GPUSOROBANのインスタンスは、OSやNVIDIAドライバ、CUDA、PyTorchなど必要なソフトウェアがあらかじめ揃えて提供できるので、面倒な環境構築をせずに済み、運用や保守のコストも大幅に抑えられます。

為替や電力コストの変動リスク回避

クラウドならデータセンターの運用費や電力にかかる費用などもまるごと含まれているため、為替の変動や電気料金の上昇によるリスクを減らすことができます。

最新GPUをクラウドで!導入成功事例から見たGPUSOROBANの特徴

GPUSOROBANは、AWS・GCP・Azureなど大手クラウドと比較して70%安い業界最安級の料金で利用でき、追加のデータ転送料も不要です。

また長期割と台数割を組み合わせて、「1億円の割引」が適用されるプランがあります。

ここからは、実際に GPUSOROBANを導入した企業の声をご紹介します。

さらに、導入成功事例から見た GPUSOROBANの特徴について、わかりやすく解説していきます。

A社:画像生成AI分野でのモデルトレーニング

- GPUSOROBAN上でインフラを最適化することで、オンプレミスや他クラウドよりもコストを抑えながら、学習パフォーマンスを維持できるようになりました。

- 必要に応じてGPUリソースを柔軟に増減できるため、大掛かりな設備変更を行わずに、タスク単位で最適なコストバランスを取れるようになりました。

- NVIDIA H200以外のサービスプランでも従量課金制が採用されており、1時間あたり50円から始められる手軽なプランがある点は非常に魅力的です。

B社:製薬研究にAIを用いてデータを解析

- 以前は、GCPのNVIDIA T4 GPUインスタンスを使い、システムを構築していましたが、AIの進化によって計算リソース確保が追い付かなくなってしまいました。

- NVIDIA H200を提供する複数のGPUクラウドサービスを検討した結果、GPUSOROBANが最もコストパフォーマンスに優れていることがわかりました。

- 結果、グローバルモデル比で処理精度が15%向上、レスポンス時間も40%短縮することができました。

C社:日本語生成AIサービスのスタートアップ

- GPUSOROBANのインスタンスには、機械学習用ソフトウェアがあらかじめ入っているので、クラウドの専門知識がなくても簡単に導入できました。

- 料金面だけでなく、セットアップの手軽さも含めてすぐに始められました。

- 国内のデータセンターを利用することでレイテンシーが低くなっているおかげで、LLMデータセットも効率よく学習できるようになり、最適なモデル訓練ができています。

NVIDIA H200の活用シーン

NVIDIA H200の導入は、多岐にわたる分野で顕著なメリットをもたらし、さまざまな活用シーンでその真価を発揮します。

特に、高性能計算やAI関連のワークロードにおいて、その効果は絶大です。

ビジネス用途での効果

NVIDIA H200をビジネスに導入することで、AIトレーニングやHPCにおいて大きな成果が期待できます。

H200の高い計算能力と大容量メモリにより、AIモデルのトレーニング時間を大幅に短縮し、より迅速な製品開発やサービス提供が可能になります。

自然言語処理、画像認識、レコメンデーションシステムなどのAIアプリケーションの精度向上や応答速度の改善に貢献します。

また、複雑なデータ解析やシミュレーションを高速に実行できるため、研究開発のサイクルを加速し、ビジネスにおける競争力を強化できます。

用途別にGPUを選択するポイント

NVIDIA H200を選択する際は、その用途に応じた性能とコストを考慮する必要があります。

大規模言語モデルのトレーニングや、非常に大きなデータセットを扱うHPCワークロードには、H200の大容量メモリと高いメモリ帯域幅が大きな強みとなります。

一方、比較的規模の小さいAIタスクやHPCワークロードであれば、NVIDIA H100やNVIDIA A100でも十分な性能が得られる場合があります。

予算や既存のインフラストラクチャとの互換性も考慮に入れ、最適なGPUを選択することが重要です。

NVIDIA H200に関するQ&A事例

次世代GPUと今後の展望

NVIDIAはNVIDIA H200に続く次世代GPUの開発も進めており、GPU技術は今後もさらなる進化が期待されます。

近年のAI/HPC需要を背景に、演算性能・省電力性・メモリ帯域の強化に加え、クラウドやエッジでの展開に向けた柔軟なソフトウェア対応が進むことはほぼ確実です。

これらの技術革新は、AI、HPC、そして様々な産業分野に大きな影響を与えるでしょう。

クラウドGPUを使うなら「GPUSOROBAN」がおすすめ

GPUSOROBAN(ジーピーユーソロバン)は、純国産GPUクラウドです。

累計2,000件を越えるご利用実績があり、IT業界、製造業、建設業、大学研究機関まで幅広くご利用いただいています。

AIスパコンクラウドでは、HGX H200を圧倒的な低価格でご利用いただけます。今なら無料トライアル実施中です。

GPUSOROBANが選ばれる3つの理由

ポイント1

圧倒的な低価格!月額固定料金

HGX H200を自社で導入する場合、大規模な電源や空調設備、サーバールームなどの設備投資が必要です。

AIスパコンクラウドでは、初期費用が無料で、月額料金のみでHGX H200を利用可能です。

さらに、AWS H100と比較しても上位機種なのに70%安い料金で提供予定です。また、日本円払いのため為替の変動を気にせずに安心して利用できます。

ポイント2

日本語での技術サポートが無料

GPUSOROBANでは、豊富な知識をもった専門スタッフによる日本語での技術サポートを無料で提供しています。

基本的な使い方のレクチャーからGPU動作に関する環境構築まで幅広くサポートします。

さらに、個別カスタマイズ対応も提供しており、安心してご利用いただけます。

ポイント3

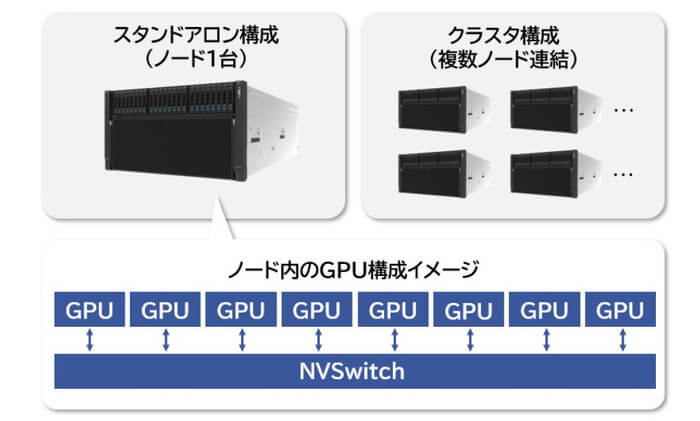

1台からクラスタ構成(複数連結)まで柔軟に対応

GPUSOROBANでは、H200搭載サーバーを1台から利用可能です。

さらに、H200搭載サーバーを連結したクラスタ構成も利用できるため、必要なリソースだけを選んで活用できます。

もちろん、連結にはH200 SXMのパフォーマンスを最大限に引き出すNVLink・NVSwitchを利用しています。

NVIDIA H200の豊富な知識を持ったスタッフが、わかりやすくご説明いたしますのでまずはお気軽にご相談ください。

まだまだ知りたいあなたへ!関連情報を集めました!

本記事でご紹介した内容に関連するトピック記事をまとめました。

より深く知りたい方は、ぜひ合わせてご覧ください。