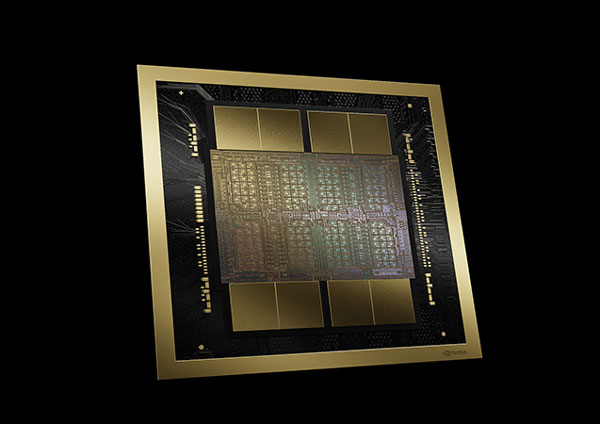

半導体大手メーカーNVIDIA(エヌビディア)は、2024年3月18日にAI向けの画像処理装置(GPU)の新製品を発表しました。

開発者会議の会場のスタジアムには1万人以上が来場し、世界中で大きな注目を集めています。

この記事では、最新のGPUモデル「Blackwell(ブラックウェル)」について詳しく解説します。

最新のGPU「Blackwell」とは?

NVIDIAは、ゲームや高度なデータ処理向けのパソコンパーツである画像処理半導体(GPU)を販売しているメーカーです。

「Blackwell」は、AIモデルの学習や実行に特化したGPUの新ブランドになります。

また、チップ間を接続するNVLinkが第5世代に進化することも同時に発表されました。

「Blackwell」の特徴を発表された内容から3つにまとめました。

- 旗艦チップ製品名は「Blackwell B200」2025年後半からの市場へ

- 信頼性、可用性、サービス性が向上され、セキュリティ性能がUP

- 新たなシステムの導入により、大幅に処理能力が上がり、更に省電力化も達成

Blackwell B200とは?

「Blackwell」とは、新たなGPUアーキテクチャ(システム様式)で、NVIDIAが独自に名付けたブランド名です。

「B200」は、今回のメインとなるGPUで基本パーツとなっています。

今回発表されたラインナップは、次の3種です。

- AI・データセンター向けのGPU「H100」の後継となる「B200」

- Arm CPUと組み合わせた「GH200」の後継となる「GB200」

- ラック版の8GPU構成のサーバー機器「DGX H100」の後継「DGX B100」

各チップを搭載した製品は、2025年後半からの市場投入を予定しています。

なお、Blackwellを搭載したクラウドサービスは、AWS、Google、Microsoft、Oracleが2024年後半に提供を始める予定と発表しています。

パフォーマンスの⾼い機密コンピューティングと安全な AI

NVIDIAは、AIビジネスへのサービス提供支援の中で、プライベートデータや機密情報をトレーニングデータとして扱う場合のリスクについて言及しています。

従来はCPU内で切り分けて実行環境を構築していたTEEをGPUに拡張してサポートを行う機能を業界で初めて導入します。

これによって、⾮暗号化モードと⽐較してほぼ同⼀のスループットパフォーマンスを実現し、機密データを利用してののトレーニング、推論、フェデレーテッドラーニングを安全に実現できるようになります。

新たに搭載される「RASエンジン」によってダウンタイムを最小限に抑え、時間、エネルギー、コンピューティング コストを節約するシステムが構築されます。

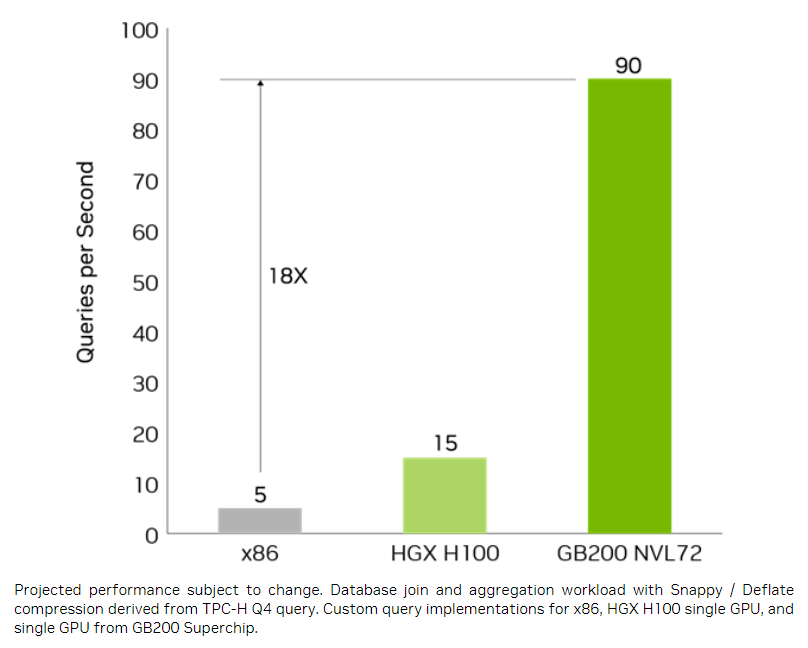

Blackwellの性能比較

実際にBlackwellと現行GPU( Hopper GPU 世代)H100の性能を比較してみたいと思います。

Blackwellの新しいエンジンは、GB200のGPUとGrace CPUの高速 NVLink-C2C (チップto-Chip) 相互接続により、圧倒的なパフォーマンスを出すと予想されています。

データ分析とデータベースのクエリベンチマークにおいて CPUより18倍、NVIDIA H100より6倍高速に実行できています。

それ以外にも、リアルタイムでの推論パフォーマンスや、エネルギー使用量なども前例のないレベルの効率を実現できると言われています。

\こちらの資料から詳細を確認することができます/

BlackwellはAIのインフラを担う重要な次世代チップ

AIが発達する裏には高性能の処理能力が不可欠です。

Blackwellは、AIが生活に浸透し進化していくにあたって、重要なポイントになっていくでしょう。

今後もNVIDIAの発表に注目です。

出典:NVIDIA