Stable Diffusionで高品質な画像生成を行う際、GPUメモリ不足は多くのユーザーが直面する悩みのひとつです。

突然のエラーや処理速度の低下を防ぎ、快適なクリエイティブ体験を維持するためには、メモリの使い方や設定の工夫が欠かせません。

本記事では、初心者から上級者まで役立つStable Diffusionのメモリ節約テクニックやおすすめ設定、実践的な対策方法をわかりやすく解説します。

Stable Diffusionメモリ不足の原因とは?

Stable Diffusionで「メモリ不足」が発生する主な原因は、モデルの動作に必要なGPU(グラフィックボード)のVRAMが足りなくなることを指します。

以下に、よくある具体的な原因をまとめました。

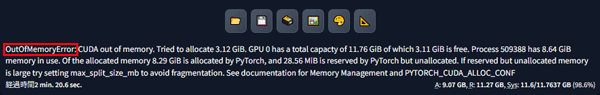

out of Memory エラー

out of Memoryエラーは、Stable Diffusionや学習系アプリでよく見られる代表的なエラーです。

これは、CUDA使用時にGPUのVRAM(グラフィックボードのメモリ)が足りないときに発生します。

・画像生成時に高解像度や大きなバッチサイズを指定した場合

・SDXLや大きなLoRAなど、重いモデルを使った場合

・ControlNetやアップスケールなどの追加機能を同時に使った場合

・他のGPU利用アプリが同時に動いている場合

VRAMの役割と必要容量

Stable Diffusionの生成で消費するVRAMの目安表

| モデル・設定 | 画像サイズ | バッチ | 必要VRAM目安 | 備考 |

| SD 1.5(軽量) | 512×512 | 1 | 4GB〜6GB | GTX1660, RTX2060などで動作可能 |

| SDXL(大型) | 1024×1024 | 1 | 10GB〜12GB | RTX3080, RTX4080推奨 |

| ControlNet併用 | 512×512 | 1 | 8GB以上 | 拡張機能で消費が増える |

| バッチ生成(複数) | 512×512 | 2〜4 | 8GB〜16GB | バッチ数を増やすと急増 |

- VRAMを大きく消費する場面

- モデルのロード

-

Stable Diffusionのニューラルネットワーク(重みやパラメータ)がVRAM上に展開されます。

- 画像生成の計算処理

-

入力データ(ノイズや特徴マップ)、モデル推論の中間データがVRAM上で計算されます。

- バッチ生成や拡張機能の利用

-

一度に複数画像を生成したり、ControlNetやアップスケールなど追加機能もVRAMを消費します。

- VAE/LoRA/追加モデルの読み込み

-

VAEやLoraなどを使うと、その分VRAM使用量が増えます。

Stable Diffusion でのVRAMの定義は「モデルや画像データを計算したり保持するための作業スペース」として考えられています。

必要容量は使うモデル・画像サイズ・バッチ数・拡張機能などで大きく変わります。

一般的な用途なら6GB以上、本格的に使うなら10GB以上がおすすめです。

Stable Diffusionを低VRAM環境で動かす方法

Stable Diffusionは、低VRAMの環境(例: 2〜6GBのGPU)でも工夫次第で動作が可能です。

ここから解説するテクニックを利用してリソースを節約してパフォーマンスを上げましょう。

xformersを導入する

「xformers」はStable Diffusionでの画像生成を最適化するだけでなく、VRAMの使用量も抑えてくれる機能で、導入後は最大約2倍の生成速度となります。

xformersの導入は、利用メモリ量に余裕がない低スペックのGPUほど効果を発揮する特徴があります。

ただし、xformersを導入できるのは、NVIDIA製のGPUを利用しているPC環境のみなので注意しましょう。

設定方法は簡単で、起動ファイルに以下のように1行のスクリプトを追加するだけです。

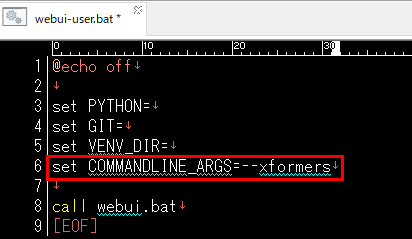

「webui-user.bat」ファイルを開いて編集します。

6行目のset COMMANDLINE_ARGS=の後に-xformersを入力して保存します。

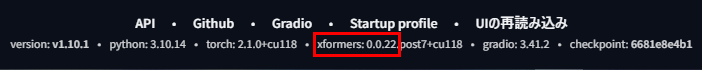

Stable Diffusionを起動して画面下部にxformersが実装されているのを確認します。

「低VRAM」オプションを追加する

VRAMの少ないPC環境でStable Diffusionを高速化して動作させるために、オプションを付けて起動します。

VRAM使用量を節約してソフトウエアを起動することで全体の動きが軽くなり、高速化につながります。

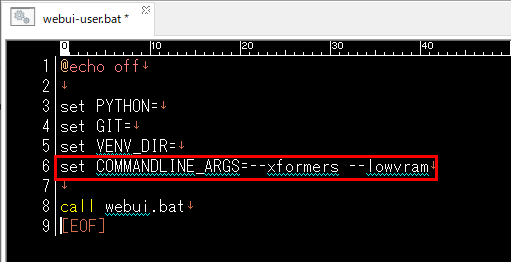

設定方法はxformersと同じで、起動ファイルに1行のスクリプトを追加するだけです。

下の画像のように–medvram(効果:中)と–lowvram(効果:強)を使い分けます。

その他のオプションを使う

その他にもStable Diffusionを高速化させるオプションには以下があります。

- –skip-prepare-environment

環境の準備をスキップするオプションで、環境の準備をスキップすることで起動が早くなり、Stable Diffusionが高速化します。

- –skip-torch-cuda-test

CUDAが正常に動作するかのチェックをスキップするオプションです。

ただし、異常が起きた場合に検知できないので、急いでいる場合にのみ使うようにしましょう。

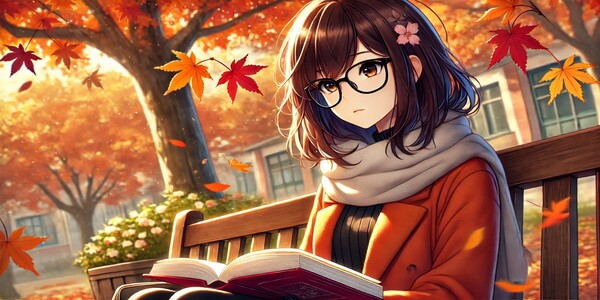

解像度を下げて、後から拡大する

Stable Diffusionにおいて、まず低解像度で画像を生成し、その後でアップスケールする手法により、低VRAM環境での安定性と処理速度を大幅に向上させることができます。

次のステップで拡大画像を生成してみましょう。

SD1.5の場合は、ベース: 512×512に設定し、アスペクト比を保って512〜768程度に抑えて調整します。

SDXLの場合は、832px~1024pxに設定して調整します。

512px×512px

SD1.5

1024px×1024px

SDXL

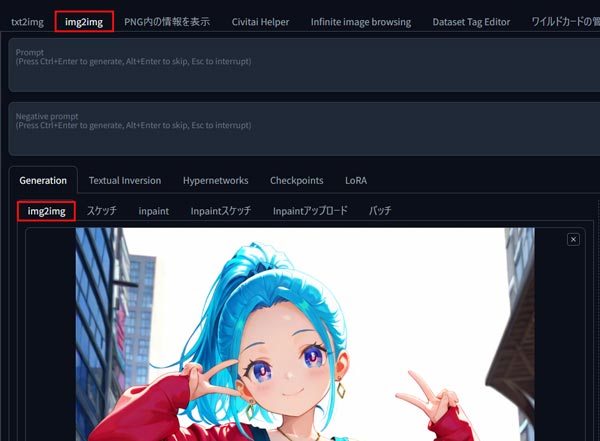

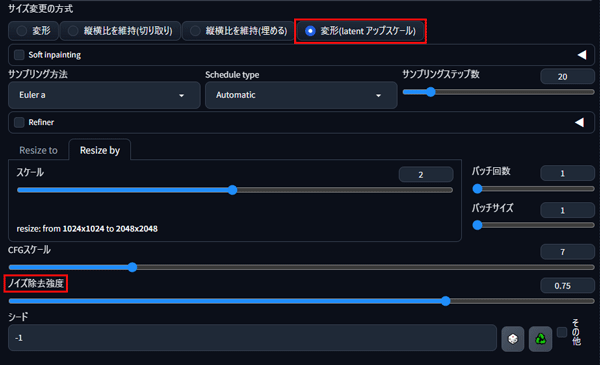

今回は。img2imgのリサイズを利用して拡大画像を生成します。

img2imgのタブから画像を読み込みます。

ノイズ除去強度をコントロールしながら生成を繰り返します。

ノイズ除去強度を上げるほど前回の結果からの変化量が大きくなり、低くするほど細部の維持と微調整に向きます。

まずは0.3前後で数回試し、ディテールが潰れるようなら0.2付近に下げ、構図や大きな形を大胆に変えたい場合は0.5付近まで上げて様子を見ましょう。

1024px×1024px

SD1.5

2048px×2048px

SDXL

Webブラウザのメモリ解放を定期的に行う

Stable Diffusionで使用しているブラウザのメモリ解放を行うことで動作が軽くなる場合があります。

利用しているブラウザに応じて機能を使い分けます。

- Google Chrome:「メモリセーバー」を有効化

手順:設定 > パフォーマンス > メモリセーバー をオン

効果:非アクティブなタブのメモリ使用量を削減

- Microsoft Edge:「スリーピング タブ」を有効化

手順:設定 > システムとパフォーマンス > スリーピング タブ をオン

効果:使っていないタブを自動的に休止してメモリを解放

Stable Diffusionのメモリ不足を根本から解決する方法

Stable Diffusionにおいてのメモリ不足を根本から解決する方法は、大きく2つあります。

1) VRAMを増やす(GPUの買い替え/増強)

2) クラウドGPUへ移行する

各対策について下記にまとめました。

おすすめのグラフィックボード

VRAMを増やす選択肢として、グラフィックボードの買い替えや増設が有効です。

グラフィックボード選びは、用途と予算、そしてタイミングで最適解が大きく変わります。

ここでは、現在入手しやすい現行モデルの中から、用途別・価格帯別におすすめできるグラフィックボードを厳選し、主な機能やスペックをわかりやすく紹介します。

RTX 5090

RTX 5090の主要スペック

| 項目 | スペック |

| 価格 | \425,040 |

| メモリ容量 | 32GB |

| メモリバス幅 | 1792GB/s |

| CUDAコア | 21760 |

| 消費電力(TPD) | 575W |

| 主な利用用途 | AI開発 |

RTX 5090は、NVIDIA の最新のBlackwellアーキテクチャをベースにしており、前世代のAda Lovelaceアーキテクチャ(RTX 4090)と比較して大きく性能が上がっています。

4K/8Kゲーミングに最適化されており、圧倒的な処理能力によって4K解像度でも高フレームレートで快適にプレイできます。

RTX 5080

RTX 5080の主要スペック

| 項目 | スペック |

| 価格 | \164,800 |

| メモリ容量 | 16GB |

| メモリバス幅 | 960GB/s |

| CUDAコア | 10752 |

| 消費電力(TPD) | 360W |

| 主な利用用途 | AI動画生成、LLM推論 |

RTX 5080は、ゲーミングからクリエイティブ制作、VR、AI処理まで幅広く対応できるパワフルなハイエンドGPUです。

レイトレーシングやAIの機能を使うことで、映像がもっときれいになり、動きもなめらかになります。

RTX 5070Ti

RTX 5070Tiの主要スペック

| 項目 | スペック |

| 価格 | \128,000 |

| メモリ容量 | 16GB |

| メモリバス幅 | 896GB/s |

| CUDAコア | 8960 |

| 消費電力(TPD) | 300W |

| 主な利用用途 | AR/VR・画像生成 |

GeForce RTX 5070 Tiは、RTX 50シリーズの中でも性能と価格のバランスに優れた上位ミドルクラスのグラフィックボードです。

AIを活用したレンダリングや本格的なレイトレーシング、DLSS 4による高フレームレートなゲームプレイに強く、さらにNVIDIA Studio対応で動画編集や3D制作などのクリエイティブ作業も快適にこなせます。

おすすめの低価格GPUクラウドサービス3選

Stable Diffusionのメモリ不足への対策として、注目すべき選択肢のひとつがGPUクラウドサービスです。

GPUクラウドサービスは、初期投資ゼロで、必要な時だけハイエンドGPUを利用可能なレンタルサービスです。

例えば、RTX 4090相当の性能を時間あたり100円前後で使えるサービスも登場しています。1日8時間使っても月額2万円程度。購入の1/10以下のコストで、メモリ不足から完全に解放されます

国内のGPUクラウドの利用は急速に拡大しており、特にAI開発や研究分野での需要が高まっています。

ここで紹介するデータセンター3社は、国内データセンターの利用によるデータ所在地の明確化、日本語でのきめ細やかなサポート、そして日本市場のニーズに合わせた料金体系やサービス内容が特徴となっています。

GPUSOROBAN

ハイレゾのGPUクラウド「GPUSOROBAN」は、株式会社ハイレゾが展開する国内向けGPUクラウドサービスで、優れたコストパフォーマンスが大きな強みです。

シンプルな設計のおかげでインスタンス構築が短時間で済むため、クラウド運用の経験が浅い人でも手軽に使い始められます。

時間単位の料金設定がされており、1時間50円からという業界最安級の料金でNVIDIAの高性能GPUインスタンスを利用できるとされています。

WebARENA IndigoGPU

WebARENA IndigoGPUは、NTTPCコミュニケーションズが提供するGPUクラウドサービスで、NVIDIA H200GPUを搭載したGPUインスタンスを低コストで利用できるIaaS型のサービスです。

Lambda GPU Cloud

Lambda GPU Cloudは、特にAI(人工知能)や機械学習、大規模言語モデル(LLM)のトレーニングに特化したGPUクラウドサービスです。

高性能なGPUリソースへのアクセスと、AI開発者がすぐに作業を開始できる環境を提供することに重点を置いているので、大規模なAIモデルの開発や最先端GPUをコスト効率よく活用したい企業・研究者に最適です。

Stable Diffusionのメモリ不足はクラウドGPUで解決

Stable DiffusionのVRAM不足は、クラウドGPUで即解決。

GPUSOROBANは、SDXLや高解像、ControlNetも安定・高速に運用できます。 初期費用ゼロ、最短数分で環境準備、必要な時だけ使える従量課金でコストも最適化が可能です。導入手順、料金表、性能比較、活用事例をまとめた資料をご用意しています。

GPUSOROBAN

GPUSOROBANは、高性能なGPU「NVIDIA A4000 16GB」を業界最安値の1時間50円で使用することができます。

さらに、クラウドGPUを利用しない時は停止にしておくことで、停止中の料金はかかりません。

クラウドGPUを使えばいつでもStable Diffusionの性能をフルに引き出すことができるので、理想の環境に近づけることができます。

\快適に生成AI!1時間50円~/